Más información sobre la automatización agéntica y la orquestación con UiPath

Maestro

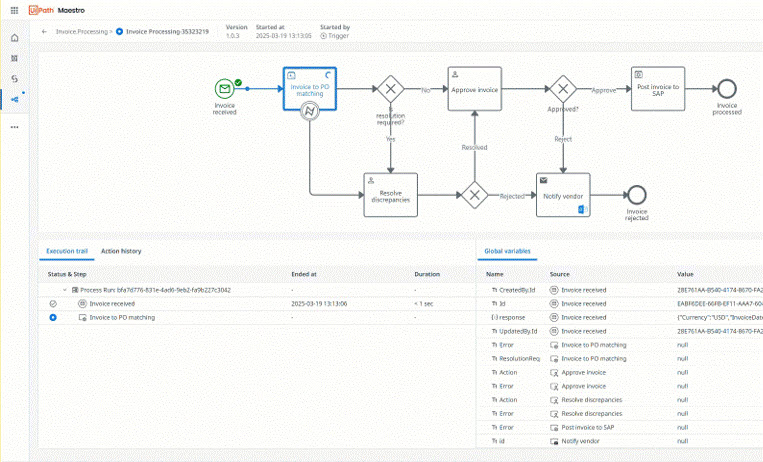

Orquesta agentes de IA, automatizaciones y personas en procesos completos para ofrecer resultados medibles

Comience con UiPath

Orquesta un proceso empresarial completo en un solo flujo de trabajo

Crea tu primer proyecto en Studio

Crea tu primer agente en Studio Web

Crea agentes conversacionales utilizando nuestro diseñador de código bajo en Studio Web

Aprende cómo los conectores proporcionan acceso seguro y estandarizado a sistemas externos

Temas populares

Permite el tráfico de red necesario para Automation Cloud

Instala Studio en tu máquina

Crea tus primeras automatizaciones paso a paso

Elige dónde se almacenan tus datos de Automation Cloud

Crea y ejecuta automatizaciones en un explorador

Novedades

Lleva el comportamiento agéntico y las capacidades cognitivas a tu escritorio

Convierte las solicitudes en lenguaje natural en flujos de trabajo BPMN

Diseña tu agente más rápido y fácil

Diseña tus pruebas automatizadas de forma segura utilizando tu propia infraestructura

AI Trust Layer y soluciones ahora disponibles en Automation Suite