- Einleitung

- Einrichten Ihres Kontos

- Ausgewogenheit

- Cluster

- Konzeptabweichung

- Abdeckung

- Datasets

- Allgemeine Felder

- Beschriftungen (Vorhersagen, Konfidenzniveaus, Beschriftungshierarchie und Beschriftungsstimmung)

- Modelle

- Streams

- Modellbewertung

- Projekte

- Präzision

- Rückruf

- Nachrichten mit und ohne Anmerkungen

- Extraktionsfelder

- Quellen

- Taxonomien

- Training

- „True“ und „false“ positive und negative Vorhersagen

- Validierung

- Messages

- Zugriffssteuerung und Administration

- Verwalten Sie Quellen und Datasets

- Verstehen der Datenstruktur und -berechtigungen

- Erstellen oder Löschen einer Datenquelle in der GUI

- Vorbereiten von Daten für den CSV-Upload

- Hochladen einer CSV-Datei in eine Quelle

- Ein Dataset wird erstellt

- Mehrsprachige Quellen und Datasets

- Aktivieren der Stimmung für ein Dataset

- Ändern der Dataset-Einstellungen

- Löschen einer Nachricht

- Löschen eines Datasets

- Exportieren eines Datasets

- Verwenden von Exchange-Integrationen

- Modelltraining und -wartung

- Grundlegendes zu Beschriftungen, allgemeinen Feldern und Metadaten

- Beschriftungshierarchie und Best Practices

- Vergleichen von Anwendungsfällen für Analyse und Automatisierung

- Konvertieren Ihrer Ziele in Bezeichnungen

- Übersicht über den Modelltrainingsprozess

- Generative Anmerkung

- Der Status des Datasets

- Best Practice für Modelltraining und Anmerkungen

- Training mit aktivierter Beschriftungs-Stimmungsanalyse

- Grundlegendes zu Datenanforderungen

- Trainieren

- Einführung in Verfeinerung

- Erläuterungen zu Präzision und Rückruf

- Präzision und Rückruf

- So funktioniert die Validierung

- Verstehen und Verbessern der Modellleistung

- Gründe für die geringe durchschnittliche Beschriftungsgenauigkeit

- Training mit Beschriftung „Überprüfen“ und Beschriftung „Verpasst“.

- Training mit der Bezeichnung „Teach“ (Verfeinern)

- Training mit der Suche (verfeinern)

- Verstehen und Erhöhen der Abdeckung

- Verbesserung des Abgleichs und Verwendung des Abgleichs

- Wann das Training Ihres Modells beendet werden soll

- Verwenden von allgemeinen Feldern

- Generative Extraktion

- Verwenden von Analyse und Überwachung

- Automations and Communications Mining™

- Entwickler (Developer)

- Verwenden der API

- API-Tutorial

- Quellen

- Datasets

- Anmerkungen

- Anhänge (Attachments)

- Vorhersagen

- Erstellen Sie einen Stream

- Aktualisieren Sie einen Stream

- Rufen Sie einen Stream nach Namen ab

- Rufen Sie alle Streams ab

- Löschen Sie einen Stream

- Ergebnisse aus Stream abrufen

- Kommentare aus einem Stream abrufen (Legacy)

- Bringen Sie einen Stream vor

- Einen Stream zurücksetzen

- Kennzeichnen Sie eine Ausnahme

- Entfernen Sie das Tag einer Ausnahme

- Prüfungsereignisse

- Alle Benutzer abrufen

- Hochladen von Daten

- Herunterladen von Daten

- Exchange Integration mit einem Azure-Dienstbenutzer

- Exchange-Integration mit der Azure-Anwendungsauthentifizierung

- Exchange-Integration mit Azure Application Authentication und Graph

- Abrufen von Daten für Tableau mit Python

- Elasticsearch-Integration

- Allgemeine Feldextraktion

- Selbst gehostete Exchange-Integration

- UiPath® Automatisierungs-Framework

- Offizielle UiPath®-Aktivitäten

- Wie Maschinen lernen, Wörter zu verstehen: eine Anleitung zu Einbettungen in NLP

- Eingabeaufforderungsbasiertes Lernen mit Transformers

- Ef Robots II: Wissensdegesterration und Feinabstimmung

- Effiziente Transformer I: Warnmechanismen

- Tief hierarchische, nicht überwachte Absichtsmodellierung: Nutzen ohne Trainingsdaten

- Beheben von Anmerkungsverzerrungen mit Communications Mining™

- Aktives Lernen: Bessere ML-Modelle in weniger Zeit

- Auf Zahlen kommt es an – Bewertung der Modellleistung mit Metriken

- Darum ist Modellvalidierung wichtig

- Vergleich von Communications Mining™ und Google AutoML für Conversation Data Intelligence

- Lizenzierung

- Häufige Fragen und mehr

Communications Mining-Benutzerhandbuch

Verstehen und Erhöhen der Abdeckung

Sie müssen die Berechtigungen Quelle – Lesen und Dataset – Überprüfen als Automation Cloud-Benutzer oder die Berechtigungen Anzeigen und Überprüfen und Kommentieren als Legacy-Benutzer zugewiesen haben.

Die Abdeckung ist ein Begriff, der häufig im Machine Learning verwendet wird und sich darauf bezieht, wie gut ein Modell die Daten „abdeckt“, die es analysiert wird. In der Plattform bezieht sich dies auf den Anteil der Nachrichten im Dataset, die über informative Beschriftungsvorhersagen verfügen, und wird in der Validierung als prozentuale Punktzahl angezeigt.

Informative Beschriftungen sind solche Beschriftungen, die die Plattform als nützlich für eigenständige Beschriftungen versteht, indem die Häufigkeit berücksichtigt wird, mit der sie mit anderen Beschriftungen zugewiesen werden. Beschriftungen, die immer mit einer anderen Beschriftung zugewiesen sind, z. B Übergeordnete Beschriftungen, die nie selbst zugewiesen werden, oder „Dringend“, wenn sie immer mit einer anderen Beschriftung zugewiesen sind, werden bei der Berechnung der Punktzahl nach unten gewichtet.

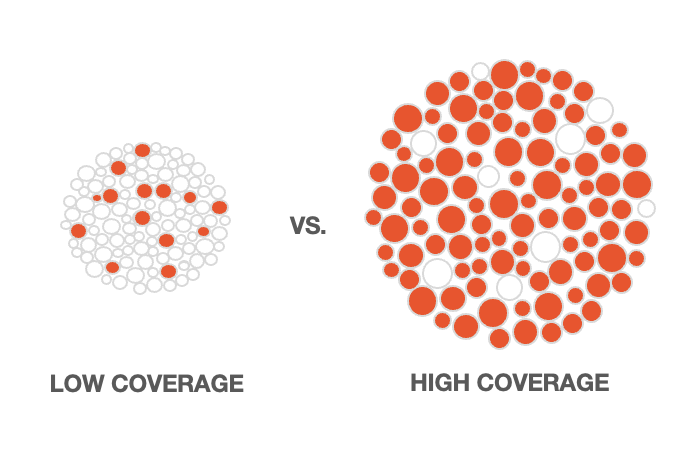

Die folgende Abbildung gibt einen Eindruck davon, wie eine geringe Abdeckung im Vergleich zu einer hohen Abdeckung in einem gesamten Dataset aussehen würde. Stellen Sie sich vor, dass die schattierten Kreise Nachrichten sind, die informative Beschriftungsvorhersagen haben.

Als Metrik ist die Abdeckung sehr hilfreich, um nachvollziehen, ob Sie all die verschiedenen potenziellen Konzepte in Ihrem Dataset erfasst haben und ob Sie ihnen genügend vielfältige Trainingsbeispiele zur Verfügung gestellt haben, damit die Plattform sie effektiv vorhersagen kann.

In fast allen Fällen ist die Abdeckung des Modells umso besser, je höher die Abdeckung ist. Dies sollte jedoch bei der Überprüfung der Modellleistung nicht isoliert betrachtet werden.

Stellen Sie sicher, dass die Beschriftungen in der Taxonomie fehlerfrei sind, d. h. eine hohe durchschnittliche Genauigkeit und keine anderen Leistungswarnungen aufweisen, und dass die Trainingsdaten eine ausgewogene Darstellung des Datasets als Ganzes sind. Wenn Ihre Beschriftungen fehlerhaft sind oder die Trainingsdaten nicht repräsentativ für das Dataset sind, dann ist die Abdeckung Ihres Modells, die die Plattform berechnet, unzuverlässig.

Eine hohe Abdeckung Ihres Modells ist besonders wichtig, wenn Sie es zur Steuerung von automatisierten Prozessen verwenden.

Abdeckung im Kontext

Überlegen Sie, wie die Abdeckung in einem Anwendungsfall gilt, z. B. das automatische Weiterleiten verschiedener Anfragen, die in einem freigegebenen E-Mail-Posteingang in einem Unternehmen empfangen werden.

Für ein Modell, das dazu dient, verschiedene Anforderungen automatisch weiterzuleiten, würde eine geringe Abdeckung bedeuten, dass viele Anforderungen ungenau weitergeleitet oder zur manuellen Überprüfung gesendet wurden, da das Modell sie nicht identifizieren konnte.

Wenn 10 Schlüsselprozesse vom Team im Postfach verwaltet werden, die Taxonomie aber nur 7 von ihnen effektiv erfasst, führt dies wahrscheinlich zu einer schlechten Abdeckungspunktzahl. Alternativ kann das Modell die verbleibenden Prozesse fälschlicherweise als andere Prozesse vorhersagen, da nicht trainiert wurde, um welche tatsächlich es sich handelt. Dies würde zu einer künstlichen hohen Abdeckungspunktzahl führen.

Während der Automatisierung wurden die verbleibenden drei Prozesse wahrscheinlich übersehen, zur manuellen Überprüfung weitergeleitet oder fälschlicherweise als ein anderer Prozess klassifiziert und an die falsche Stelle weitergeleitet.

Es ist auch wichtig, dass für jeden der Prozesse ausreichend unterschiedliche Trainingsbeispiele vorhanden sind, die die unterschiedlichen Ausdrücke erfassen, die bei der Erörterung des Prozesses verwendet werden. Ist dies nicht der Fall, hat jede Beschriftung eine geringere Erinnerung und die Abdeckung des Modells ist niedrig.

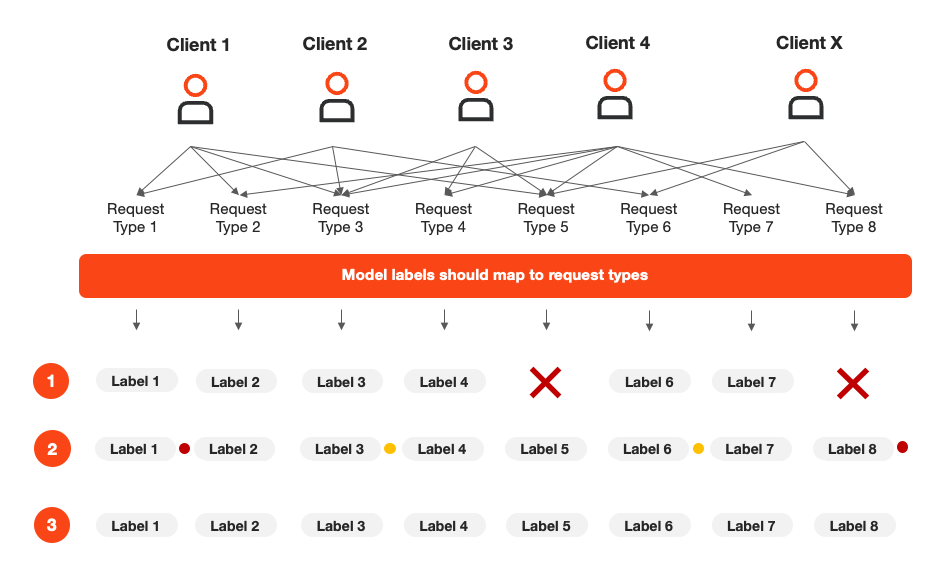

Die folgende Abbildung zeigt, wie dieses Beispiel in der Praxis aussehen könnte – wir haben mehrere Clients, die mehrere Anforderungstypen per E-Mail senden. Jeder Client kann denselben Anforderungstyp auf eine andere Weise schreiben:

Es werden drei verschiedene Modellszenarien gezeigt, die jeweils unterschiedliche potenzielle Auswirkungen auf die Abdeckung haben:

| Nicht alle Anforderungstypen, d. h. die von der Taxonomie abgedeckten Konzepte – Wahrscheinlich geringe Abdeckung |

| Alle Anforderungstypen werden abgedeckt, aber einige Beschriftungen sind fehlerhaft und haben möglicherweise nicht genügend Beispiele – Die Abdeckung kann niedrig sein und ist wahrscheinlich unzuverlässig |

| Alle abgedeckten Anforderungstypen und Beschriftungen sind alle fehlerfrei – Hohe Abdeckung, die wahrscheinlich zuverlässig ist |

Überprüfen der Modellabdeckung

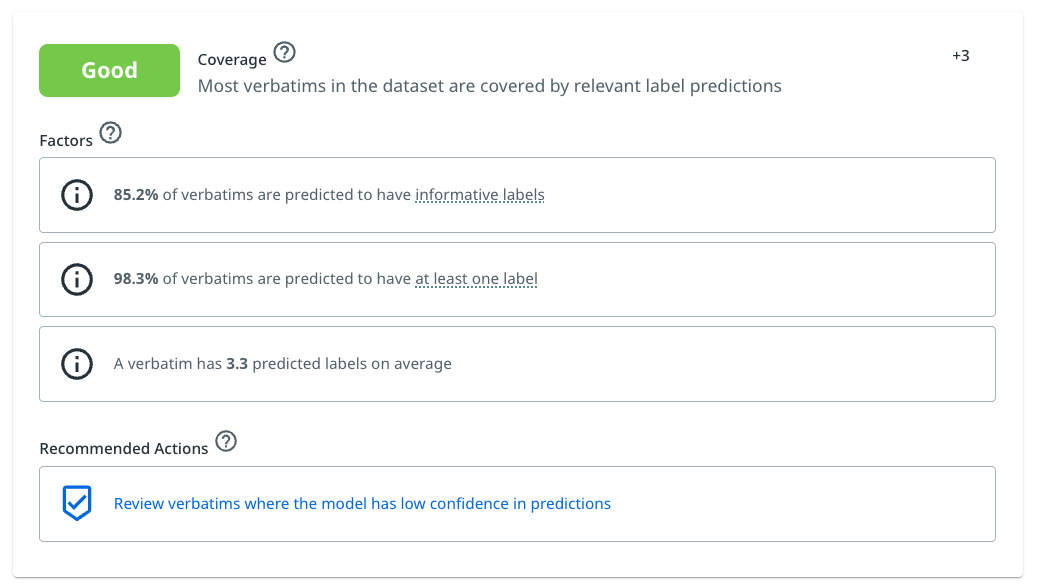

In der Validierung bietet die Funktion Modellbewertung eine detaillierte Aufschlüsselung der Modellleistung über die wichtigsten Faktoren hinweg, einschließlich Abdeckung.

Benutzer erhalten eine prozentuale Punktzahl für den Anteil von Nachrichten, für die informative Beschriftungsvorhersagen vorhergesagt werden, was wiederum mit einer Bewertung und einem Beitrag zur Gesamtmodellbewertung korreliert.

Die Plattform hat auch den Anteil der Nachrichten angegeben, die mindestens eine Bezeichnung vorhergesagt haben, aber dies bestimmt nicht die Punktzahl und die Bewertung für diesen Faktor.

Im folgenden Beispiel ist Folgendes zu sehen:

- Die Abdeckung für dieses Modell beträgt 85,2 %.

- Dies bedeutet eine Bewertung von Gut für diesen Faktor.

- Dies bedeutet auch einen positiven Beitrag zur Gesamtmodellbewertung von +3.

Beispiel für die Aufschlüsselung der Abdeckung in der Validierung

Bitte beachten Sie, dass die Abdeckung als Leistungskennzahl immer in Verbindung mit dem Zustand der Beschriftungen in der Taxonomie und der Ausgewogenheit des Datasets zu verstehen ist. Bevor Sie die von der Plattform bereitgestellte Abdeckungspunktzahl für zuverlässig halten, sollten Sie auch sicherstellen, dass Sie mindestens eine gute Bewertung für die anderen Faktoren haben, die zur Modellbewertung beitragen.

Wie hoch eine Modellabdeckung sein sollte

Ihre Abdeckung sollte mindestens hoch genug sein, dass die Plattform die Bewertung „Gut“ vergeben kann. Wenn sie dieses Phase erreicht hat, funktioniert Ihr Modell gut und Sie können es basierend auf den Anforderungen Ihres Anwendungsfalls weiter optimieren.

Genau wie Menschen haben auch Machine-Learning-Modelle ihre Grenzen, daher sollten Sie keine 100%ige Abdeckung erwarten. Sie können dem sehr nahe kommen, aber nur, wenn Ihre Daten sehr einfach sind und sich wiederholen, oder wenn Sie einen sehr hohen Anteil des Datasets mit Anmerkungen versehen.

Das Erreichen einer ausgezeichnet Bewertung kann je nach Daten schwierig sein und ist je nach Anwendungsfall nicht immer notwendig.

Für Anwendungsfälle mit Fokus auf Automatisierung ist eine hohe Abdeckung besonders wichtig, daher möchten Sie in diesen Fällen wahrscheinlich die Abdeckung so weit wie möglich optimieren und eine hervorragende Bewertung erzielen.

Bei Anwendungsfällen mit Fokus auf Analysen ist eine sehr hohe Abdeckung etwas weniger kritisch. Für Modelle reicht es oft aus, die am häufigsten vorkommenden Konzepte identifizieren zu können, da diese die größten Erkenntnisse und potenziellen Möglichkeiten für Änderungen und Verbesserungen bieten.

Es ist erwähnenswert, dass ein analyseorientiertes Modell in der Regel etwas an Genauigkeit einnimmt, um ein breites Spektrum an Konzepten in seiner Taxonomie zu erfassen.

Erhöhung der Abdeckung des Modells

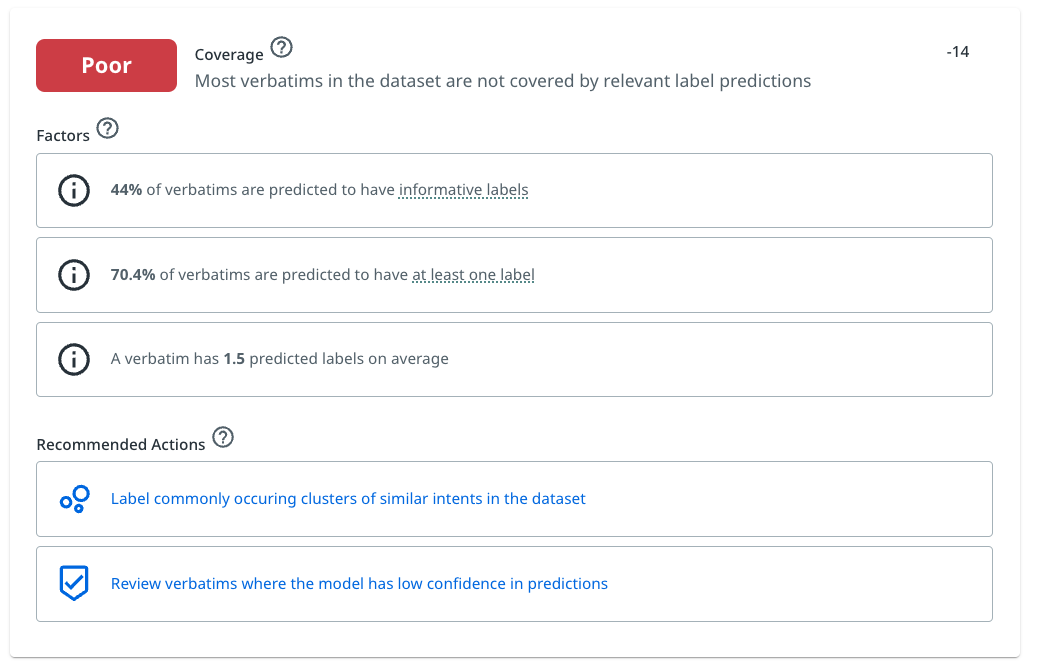

Wie auch für die anderen Faktoren, die dazu beitragen, bietet die Plattform nützliche empfohlene „nächste beste Aktionen“, die Benutzer nutzen können, um die Abdeckung Ihres Modells zu verbessern. Weitere Informationen finden Sie in den Bildern in diesem und im vorherigen Abschnitt.

Die empfohlenen Aktionen fungieren als Links, die Sie direkt zum vorgeschlagenen Trainingsmodus führen.

Im Falle der Abdeckung empfiehlt die Plattform meistens das Training im Modus „Niedrige Konfidenz“ , da dieser Modus es Benutzern ermöglicht, die am wenigsten abgedeckte aller Nachrichten im Dataset mit Anmerkungen zu versehen. Weitere Informationen finden Sie unter Training mit geringer Konfidenz.

Nach Abschluss einer angemessenen Menge an Training im empfohlenen Trainingsmodus (wie viel hängt davon ab, wie niedrig die Abdeckung zu Beginn ist) können Benutzer wieder schauen, wie sie sich verbessert hat, sobald das Modell erneut trainiert und die Validierung aktualisiert wurde. Bei Bedarf können sie den Prozess wiederholen, um ihre Punktzahlen weiter zu verbessern.

Wenn die Abdeckung sehr niedrig ist, normalerweise zu Beginn des Trainingsprozesses, kann die Plattform auch andere Trainingsmodi empfehlen, die sie für nützlich hält, wie das Versehen von Clustern ähnlicher Nachrichten in Discover mit Anmerkungen, wie im folgenden Beispiel gezeigt.

Beispiel einer Faktorkarte, die eine geringe Abdeckung für ein Modell und empfohlene Aktionen zeigt

Abdeckungsprüfung für bestimmte Bezeichnungen

Die Plattform kann auf intelligente Weise identifizieren, welche Beschriftungen in einer Taxonomie bei der Bewertung der Abdeckung eines Modells „informativ“ sind, und präsentiert dies in der Modellbewertung.

Wenn Sie jedoch den Anteil eines Datasets einschätzen möchten, der wahrscheinlich von Vorhersagen für einen bestimmten Beschriftungssatz in Ihrer Taxonomie abgedeckt wird, können Sie dies auf der Seite Berichte tun.

Dazu können Sie alle fraglichen Bezeichnungen in der Bezeichnungsfilterleiste in Berichten auswählen (wie unten gezeigt).

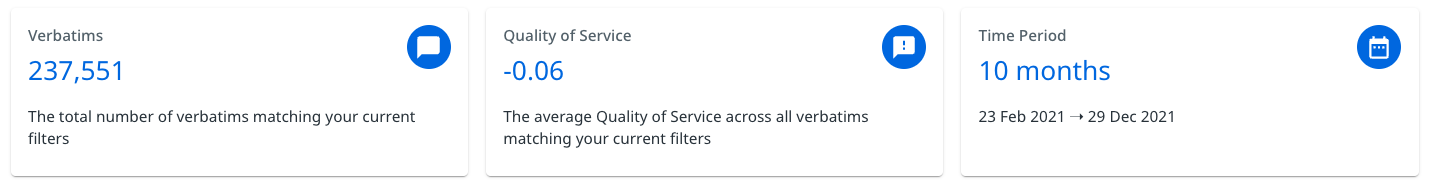

Die Nachrichtenanzahl oben auf der Seite in „Berichte“ wird basierend auf angewendeten Filtern aktualisiert. Wenn Sie Beschriftungen aus dem Beschriftungsfilter auswählen, wird die Anzahl aktualisiert, um die Anzahl der Nachrichten anzuzeigen, für die wahrscheinlich mindestens eine der ausgewählten Beschriftungen vorhergesagt wurde.

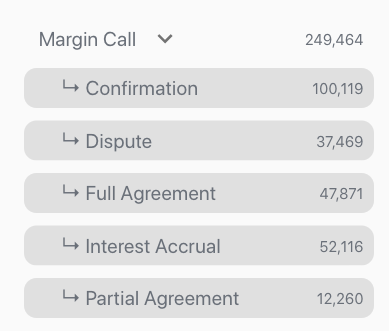

Nachrichtenanzahl in Berichten

In diesem Beispiel-Dataset von E-Mails, die sich ausschließlich auf einen Marge Call-Prozess in einer Bank beziehen (das 260.000 E-Mails enthält), können Sie sehen, dass bei 237.551 von 260.000 Nachrichten wahrscheinlich mindestens eine der ausgewählten Beschriftungen vorhergesagt wurde. Dies zeigt eine gute Abdeckung von ca. 91,4 % an.

Dies sollte nicht Ihre einzige Überprüfung sein, um die Gesamtabdeckung Ihres Modells zu testen. Das zuverlässigste Maß für die Abdeckung für das gesamte Dataset wird in der Modellbewertung dargestellt und sollte in Verbindung mit der Gesamtleistung der Beschriftungen in der Taxonomie berücksichtigt werden.