- Einleitung

- Einrichten Ihres Kontos

- Ausgewogenheit

- Cluster

- Konzeptabweichung

- Abdeckung

- Datasets

- Allgemeine Felder

- Beschriftungen (Vorhersagen, Konfidenzniveaus, Beschriftungshierarchie und Beschriftungsstimmung)

- Modelle

- Streams

- Modellbewertung

- Projekte

- Präzision

- Rückruf

- Nachrichten mit und ohne Anmerkungen

- Extraktionsfelder

- Quellen

- Taxonomien

- Training

- „True“ und „false“ positive und negative Vorhersagen

- Validierung

- Messages

- Zugriffssteuerung und Administration

- Verwalten Sie Quellen und Datasets

- Verstehen der Datenstruktur und -berechtigungen

- Erstellen oder Löschen einer Datenquelle in der GUI

- Vorbereiten von Daten für den CSV-Upload

- Hochladen einer CSV-Datei in eine Quelle

- Ein Dataset wird erstellt

- Mehrsprachige Quellen und Datasets

- Aktivieren der Stimmung für ein Dataset

- Ändern der Dataset-Einstellungen

- Löschen einer Nachricht

- Löschen eines Datasets

- Exportieren eines Datasets

- Verwenden von Exchange-Integrationen

- Modelltraining und -wartung

- Grundlegendes zu Beschriftungen, allgemeinen Feldern und Metadaten

- Beschriftungshierarchie und Best Practices

- Vergleichen von Anwendungsfällen für Analyse und Automatisierung

- Konvertieren Ihrer Ziele in Bezeichnungen

- Übersicht über den Modelltrainingsprozess

- Generative Anmerkung

- Der Status des Datasets

- Best Practice für Modelltraining und Anmerkungen

- Training mit aktivierter Beschriftungs-Stimmungsanalyse

- Grundlegendes zu Datenanforderungen

- Trainieren

- Einführung in Verfeinerung

- Erläuterungen zu Präzision und Rückruf

- Präzision und Rückruf

- So funktioniert die Validierung

- Verstehen und Verbessern der Modellleistung

- Gründe für die geringe durchschnittliche Beschriftungsgenauigkeit

- Training mit Beschriftung „Überprüfen“ und Beschriftung „Verpasst“.

- Training mit der Bezeichnung „Teach“ (Verfeinern)

- Training mit der Suche (verfeinern)

- Verstehen und Erhöhen der Abdeckung

- Verbesserung des Abgleichs und Verwendung des Abgleichs

- Wann das Training Ihres Modells beendet werden soll

- Verwenden von allgemeinen Feldern

- Generative Extraktion

- Verwenden von Analyse und Überwachung

- Automations and Communications Mining™

- Entwickler (Developer)

- Verwenden der API

- API-Tutorial

- Quellen

- Datasets

- Anmerkungen

- Anhänge (Attachments)

- Vorhersagen

- Erstellen Sie einen Stream

- Aktualisieren Sie einen Stream

- Rufen Sie einen Stream nach Namen ab

- Rufen Sie alle Streams ab

- Löschen Sie einen Stream

- Ergebnisse aus Stream abrufen

- Kommentare aus einem Stream abrufen (Legacy)

- Bringen Sie einen Stream vor

- Einen Stream zurücksetzen

- Kennzeichnen Sie eine Ausnahme

- Entfernen Sie das Tag einer Ausnahme

- Prüfungsereignisse

- Alle Benutzer abrufen

- Hochladen von Daten

- Herunterladen von Daten

- Exchange Integration mit einem Azure-Dienstbenutzer

- Exchange-Integration mit der Azure-Anwendungsauthentifizierung

- Exchange-Integration mit Azure Application Authentication und Graph

- Abrufen von Daten für Tableau mit Python

- Elasticsearch-Integration

- Allgemeine Feldextraktion

- Selbst gehostete Exchange-Integration

- UiPath® Automatisierungs-Framework

- Offizielle UiPath®-Aktivitäten

- Wie Maschinen lernen, Wörter zu verstehen: eine Anleitung zu Einbettungen in NLP

- Eingabeaufforderungsbasiertes Lernen mit Transformers

- Ef Robots II: Wissensdegesterration und Feinabstimmung

- Effiziente Transformer I: Warnmechanismen

- Tief hierarchische, nicht überwachte Absichtsmodellierung: Nutzen ohne Trainingsdaten

- Beheben von Anmerkungsverzerrungen mit Communications Mining™

- Aktives Lernen: Bessere ML-Modelle in weniger Zeit

- Auf Zahlen kommt es an – Bewertung der Modellleistung mit Metriken

- Darum ist Modellvalidierung wichtig

- Vergleich von Communications Mining™ und Google AutoML für Conversation Data Intelligence

- Lizenzierung

- Häufige Fragen und mehr

Communications Mining-Benutzerhandbuch

Elasticsearch-Integration

Communications Mining™ bietet eine Vielzahl integrierter Analysetools. Manchmal ist es jedoch erforderlich, die Vorhersagen aus Communications Mining mit Daten zu verbinden, die nicht als Teil von Communications Mining-Kommentaren hochgeladen werden können. In diesen Fällen besteht eine gängige Lösung darin, die Vorhersagen von Communications Mining und alle zusätzlichen Daten in Elasticsearch zu indizieren und ein Tool wie Kibana zu verwenden, um die Analyse zu ermöglichen. In diesem Tutorial wird beschrieben, wie Communications Mining-Daten in Elasticsearch importiert und in Kibana visualisiert werden.

Die Daten, die in den Beispielen in diesem Tutorial verwendet werden, sind generierte Dummy-E-Mails aus der Versicherungsdomäne.

Speichern von Daten in Elasticsearch

Zuerst definieren wir die Daten, die wir in Elasticsearch importieren möchten. Die Communications Mining™-API stellt den Kommentartext, Kommentarmetadaten, vorhergesagte Beschriftungen und vorhergesagte allgemeine Felder in einem verschachtelten JSON-Objekt bereit. Im Folgenden finden Sie ein Beispiel für einen unformatierten Kommentar, der von der Communications Mining-API bereitgestellt wird.

Je nachdem, wie Ihre Daten in Communications Mining aufgenommen wurden, bemerken Sie möglicherweise unterschiedliche Metadatenfelder. Weitere Informationen zu Kommentarobjektfeldern finden Sie unter Kommentare.

{

"comment": {

"id": "c7a1c529-3f57-4be6-9102-c9f892b81ae51",

"uid": "49ba2c56a945386c.c7a1c529-3f57-4be6-9102-c9f892b81ae51",

"timestamp": "2021-03-29T08:36:25.607Z",

"messages": [

{

"body": {

"text": "The policyholder has changed their address to the new address: 19 Essex Gardens, SW17 2UL"

},

"subject": {

"text": "Change of address - Policy SFG48807871"

},

"from": "CPX8460080@broker.com",

"to": ["underwriter@insurer.com"],

"sent_at": "2021-03-29T08:36:25.607Z"

}

]

// (... more properties ...)

},

"labels": [

{

"name": ["Admin"],

"probability": 0.9995054006576538

},

{

"name": ["Admin", "Change of address"],

"probability": 0.9995054006576538

}

],

"entities": [

{

"name": "address-line-1",

"formatted_value": "19 Essex Gardens",

"span": {

"content_part": "body",

"message_index": 0,

"char_start": 63,

"char_end": 79,

"utf16_byte_start": 126,

"utf16_byte_end": 158

}

},

{

"name": "post-code",

"formatted_value": "SW17 2UL",

"span": {

"content_part": "body",

"message_index": 0,

"char_start": 81,

"char_end": 89,

"utf16_byte_start": 162,

"utf16_byte_end": 178

}

},

{

"name": "policy-number",

"formatted_value": "SFG48807871",

"span": {

"content_part": "subject",

"message_index": 0,

"char_start": 27,

"char_end": 38,

"utf16_byte_start": 54,

"utf16_byte_end": 76

}

}

]

}

{

"comment": {

"id": "c7a1c529-3f57-4be6-9102-c9f892b81ae51",

"uid": "49ba2c56a945386c.c7a1c529-3f57-4be6-9102-c9f892b81ae51",

"timestamp": "2021-03-29T08:36:25.607Z",

"messages": [

{

"body": {

"text": "The policyholder has changed their address to the new address: 19 Essex Gardens, SW17 2UL"

},

"subject": {

"text": "Change of address - Policy SFG48807871"

},

"from": "CPX8460080@broker.com",

"to": ["underwriter@insurer.com"],

"sent_at": "2021-03-29T08:36:25.607Z"

}

]

// (... more properties ...)

},

"labels": [

{

"name": ["Admin"],

"probability": 0.9995054006576538

},

{

"name": ["Admin", "Change of address"],

"probability": 0.9995054006576538

}

],

"entities": [

{

"name": "address-line-1",

"formatted_value": "19 Essex Gardens",

"span": {

"content_part": "body",

"message_index": 0,

"char_start": 63,

"char_end": 79,

"utf16_byte_start": 126,

"utf16_byte_end": 158

}

},

{

"name": "post-code",

"formatted_value": "SW17 2UL",

"span": {

"content_part": "body",

"message_index": 0,

"char_start": 81,

"char_end": 89,

"utf16_byte_start": 162,

"utf16_byte_end": 178

}

},

{

"name": "policy-number",

"formatted_value": "SFG48807871",

"span": {

"content_part": "subject",

"message_index": 0,

"char_start": 27,

"char_end": 38,

"utf16_byte_start": 54,

"utf16_byte_end": 76

}

}

]

}

Das Schema der unbearbeiteten Kommentare, die von der Communications Mining-API zurückgegeben werden, ist zum Filtern und Abfragen dieser Daten in Elasticsearch ungeeignet. Daher sollten Sie das Schema ändern, bevor Sie die Daten in Elasticsearch erfassen. Im Folgenden finden Sie ein Beispiel für ein abgeflachtes Schema, das Sie verwenden können. Sie sollten alle Felder hinzufügen, die Sie für Ihren Anwendungsfall benötigen.

{

"id": "c7a1c529-3f57-4be6-9102-c9f892b81ae51",

"uid": "49ba2c56a945386c.c7a1c529-3f57-4be6-9102-c9f892b81ae51",

"timestamp": "2021-03-29T08:36:25.607Z",

"subject": "Change of address - Policy SFG48807871",

"body": "The policyholder has changed their address to the new address: 19 Essex Gardens, SW17 2UL",

// (... more fields ...)

"labels": ["Admin", "Admin > Change of address"],

"entities": {

"policy_number": ["SFG48807871"],

"address-line-1": ["19 Essex Gardens"],

"post-code": ["SW17 2UL"]

}

}

{

"id": "c7a1c529-3f57-4be6-9102-c9f892b81ae51",

"uid": "49ba2c56a945386c.c7a1c529-3f57-4be6-9102-c9f892b81ae51",

"timestamp": "2021-03-29T08:36:25.607Z",

"subject": "Change of address - Policy SFG48807871",

"body": "The policyholder has changed their address to the new address: 19 Essex Gardens, SW17 2UL",

// (... more fields ...)

"labels": ["Admin", "Admin > Change of address"],

"entities": {

"policy_number": ["SFG48807871"],

"address-line-1": ["19 Essex Gardens"],

"post-code": ["SW17 2UL"]

}

}

Ein Kommentar kann null, eine oder mehrere Beschriftungen haben, daher muss das Feld labels ein Array sein. Wenn ein oder mehrere allgemeine Feldtypen für das Dataset konfiguriert wurden, enthält ein Kommentar null, ein oder mehrere allgemeine Felder jedes allgemeinen Feldtyps. Die hierarchischen Beschriftungsnamen in der unformatierten API-Antwort sind selbst Arrays (["Admin", "Change of address"]) und sollten in Strings ("Admin > Change of address") konvertiert werden.

Abrufen von Daten

Zum Abrufen der Daten empfehlen wir die Verwendung von. Eine Übersicht über alle verfügbaren Methoden zum Herunterladen von Daten finden Sie unter Herunterladen von Daten. Beim Erstellen eines Streams sollten Sie die Schwellenwerte für jede Beschriftung so festlegen, dass Beschriftungen mit Konfidenzwerten unter dem Schwellenwert verworfen werden. Dies ist am einfachsten über die Communications Mining™-Benutzeroberfläche, indem Sie zur Seite „Streams“ eines Datasets gehen. Nachdem Sie die Konfidenzbewertungen verwendet haben, um zu bestimmen, ob eine Beschriftung zutrifft, können Sie dann nur die Beschriftungsnamen in Elasticsearch importieren. Weitere Informationen darüber, wann wir empfehlen, die Konfidenzbewertungen für Beschriftungen zu löschen oder beizubehalten, finden Sie unter Beschriftungen für Analysen.

Allgemeine Felder haben keine Konfidenzbewertungen, daher ist keine spezielle Behandlung erforderlich.

Modelländerungsverwaltung Wenn Sie einen Stream erstellen, geben Sie eine Modellversion an, die verwendet wird, um Vorhersagen beim Abrufen von Kommentaren aus dem Stream bereitzustellen. Auch wenn Sie weiterhin neue Modellversionen auf der Plattform trainieren, verwendet Ihr Stream die von Ihnen angegebene Modellversion und liefert Ihnen deterministische Ergebnisse.

Um auf eine neue Modellversion zu aktualisieren, müssen Sie einen neuen Stream erstellen, der diese Modellversion verwendet, und dann Ihren Code aktualisieren, um den neuen Stream zu verwenden. Aus diesem Grund empfehlen wir, dass Sie den Streamnamen in Ihrem Code konfigurierbar machen.

Um sicherzustellen, dass Analysen, die Vorhersagen verwenden, konsistent bleiben, sollten Sie Vorhersagen für historische Daten mithilfe der aktualisierten Modellversion erneut erfassen. Das ist möglich, indem Sie zum Zeitstempel vor Ihrem ältesten Kommentar streamen und die Daten von Anfang an erneut erfassen.

Visualisieren von Daten in Kibana

Sobald Sie die Daten in Elasticsearch indiziert haben, können Sie mit dem Erstellen von Visualisierungen beginnen. Dieser Abschnitt enthält einfache Beispiele für eine Reihe gängiger Visualisierungstools in Kibana.

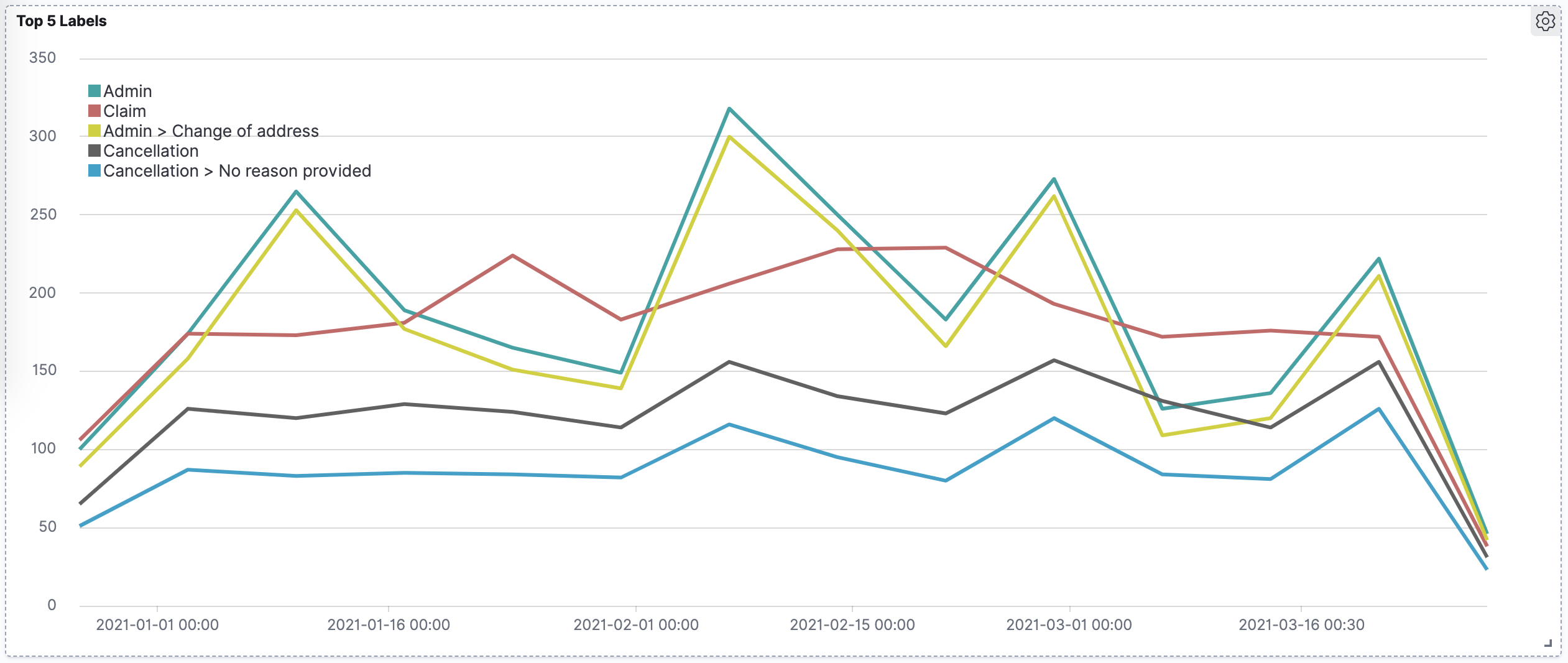

Timeout

Sie können den folgenden Ausdruck verwenden, um ein Diagramm der fünf gängigsten Beschriftungen im Zeitverlauf zu erstellen.

Hier werden sowohl die Beschriftungen der obersten Ebene als auch die Beschriftungen der Unterkategorien angezeigt.

.es(index=example-data,split=labels:5,timefield=@timestamp)

.label("$1", "^.* > labels:(.+) > .*")

.es(index=example-data,split=labels:5,timefield=@timestamp)

.label("$1", "^.* > labels:(.+) > .*")

Abbildung 1. Top 5 der Beschriftungen in einem Dataset, die im Laufe der Zeit aufgezeichnet wurden.

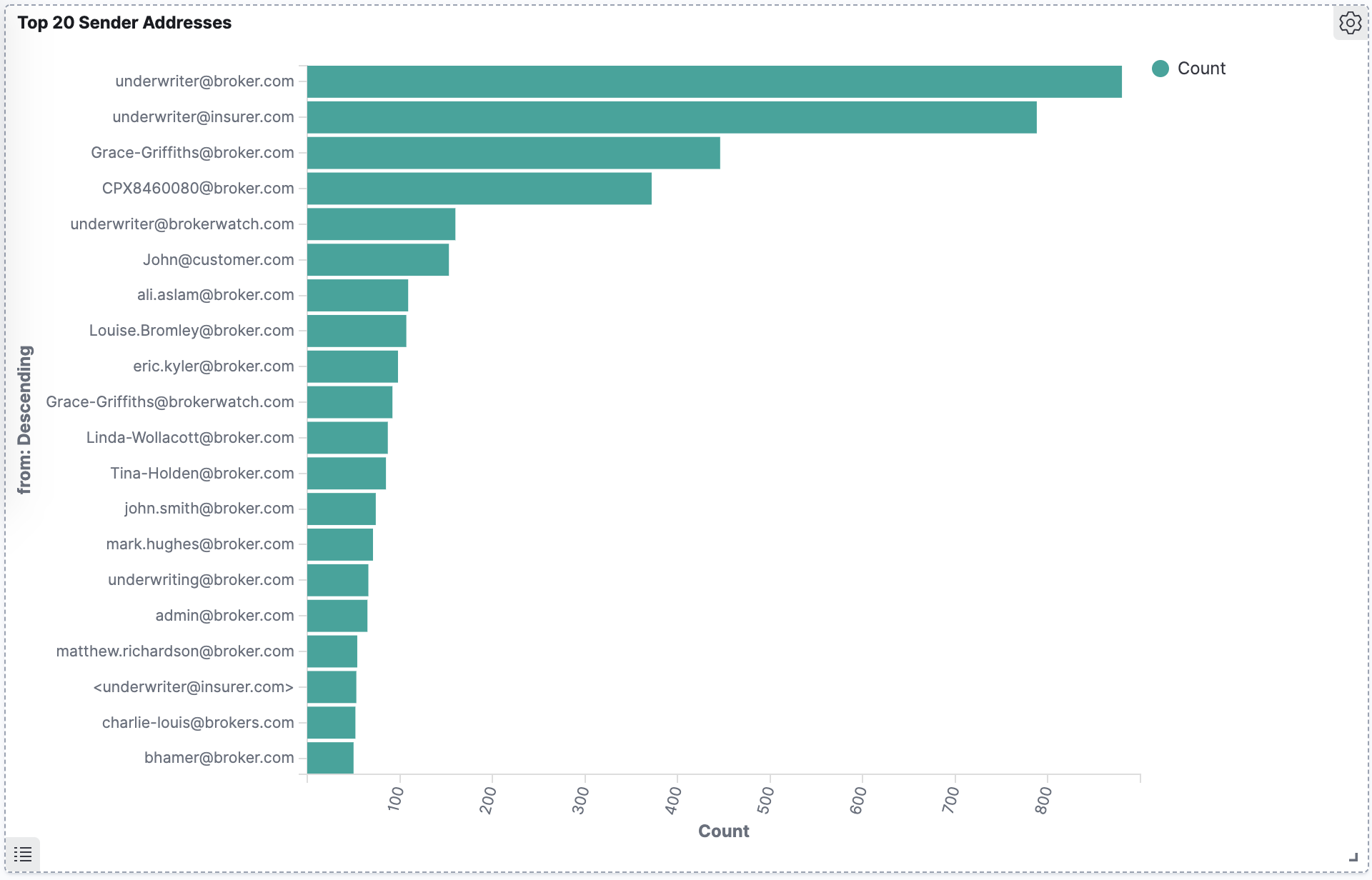

Balkendiagramm

Dieses Balkendiagramm zeigt die 20 wichtigsten E-Mail-Adressen des Absenders im Dataset. E-Mail-Adressen von Absender und Empfänger sind Teil von Kommentarmetadaten in E-Mail-basierten Datensätzen.

Abbildung 2. E-Mail-Adressen der 20 wichtigsten Absender.

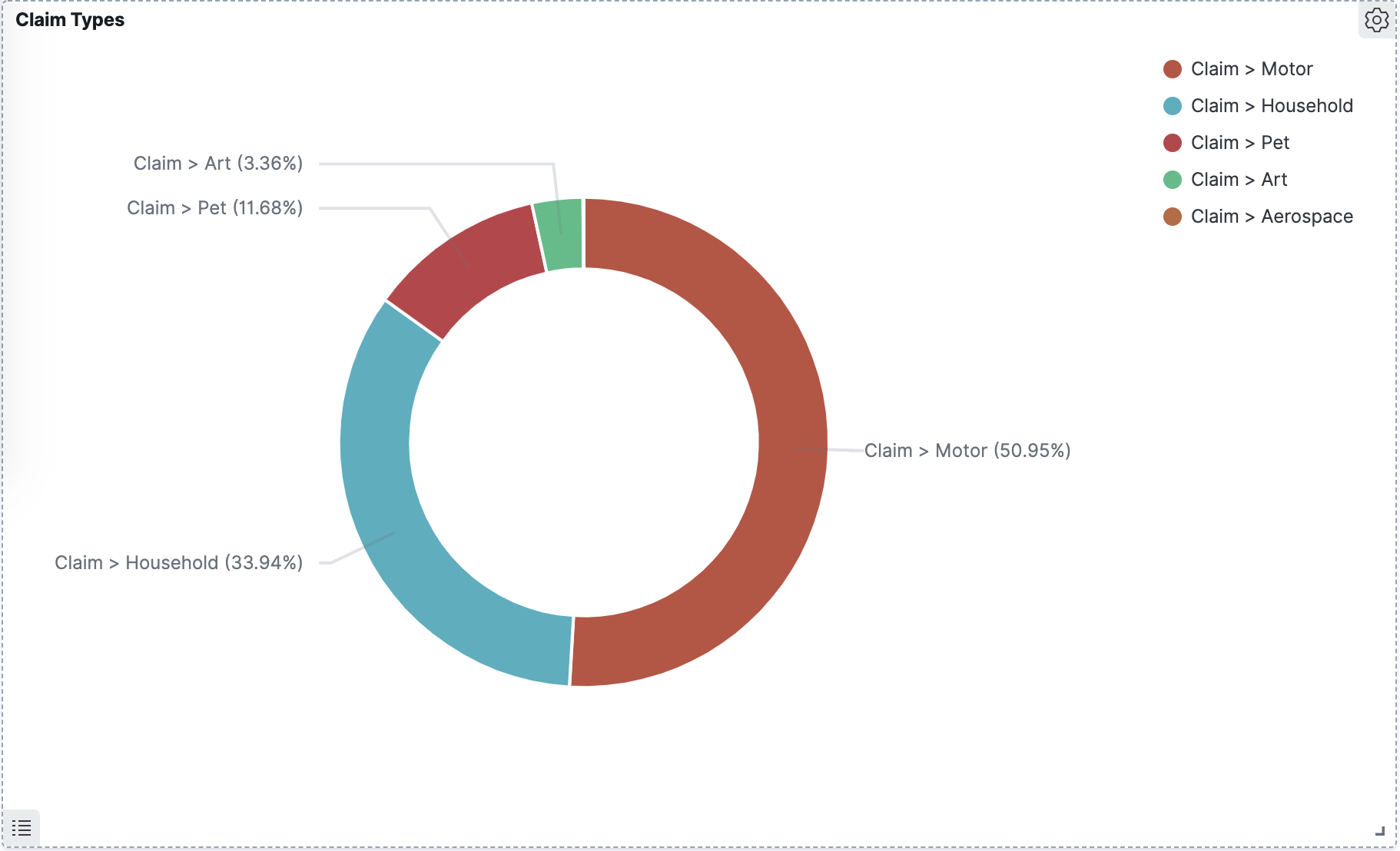

Kreisdiagramm

Dieses Kreisdiagramm zeigt Unterkategoriebezeichnungen unter der übergeordneten Beschriftung „Anspruch“ an. Die Bezeichnungskategorien werden vom Benutzer definiert, der das Modell trainiert.

Abbildung 3. Unterkategorien der Anspruchsbeschriftung.