ixp

latest

false

- Einleitung

- Einrichten Ihres Kontos

- Ausgewogenheit

- Cluster

- Konzeptabweichung

- Abdeckung

- Datasets

- Allgemeine Felder

- Beschriftungen (Vorhersagen, Konfidenzniveaus, Beschriftungshierarchie und Beschriftungsstimmung)

- Modelle

- Streams

- Modellbewertung

- Projekte

- Präzision

- Rückruf

- Nachrichten mit und ohne Anmerkungen

- Extraktionsfelder

- Quellen

- Taxonomien

- Training

- „True“ und „false“ positive und negative Vorhersagen

- Validierung

- Messages

- Zugriffssteuerung und Administration

- Verwalten Sie Quellen und Datasets

- Verstehen der Datenstruktur und -berechtigungen

- Erstellen oder Löschen einer Datenquelle in der GUI

- Vorbereiten von Daten für den CSV-Upload

- Hochladen einer CSV-Datei in eine Quelle

- Ein Dataset wird erstellt

- Mehrsprachige Quellen und Datasets

- Aktivieren der Stimmung für ein Dataset

- Ändern der Dataset-Einstellungen

- Löschen einer Nachricht

- Löschen eines Datasets

- Exportieren eines Datasets

- Verwenden von Exchange-Integrationen

- Modelltraining und -wartung

- Grundlegendes zu Beschriftungen, allgemeinen Feldern und Metadaten

- Beschriftungshierarchie und Best Practices

- Vergleichen von Anwendungsfällen für Analyse und Automatisierung

- Konvertieren Ihrer Ziele in Bezeichnungen

- Übersicht über den Modelltrainingsprozess

- Generative Anmerkung

- Der Status des Datasets

- Best Practice für Modelltraining und Anmerkungen

- Training mit aktivierter Beschriftungs-Stimmungsanalyse

- Grundlegendes zu Datenanforderungen

- Trainieren

- Einführung in Verfeinerung

- Erläuterungen zu Präzision und Rückruf

- Präzision und Rückruf

- So funktioniert die Validierung

- Verstehen und Verbessern der Modellleistung

- Gründe für die geringe durchschnittliche Beschriftungsgenauigkeit

- Training mit Beschriftung „Überprüfen“ und Beschriftung „Verpasst“.

- Training mit der Bezeichnung „Teach“ (Verfeinern)

- Training mit der Suche (verfeinern)

- Verstehen und Erhöhen der Abdeckung

- Verbesserung des Abgleichs und Verwendung des Abgleichs

- Wann das Training Ihres Modells beendet werden soll

- Verwenden von allgemeinen Feldern

- Generative Extraktion

- Verwenden von Analyse und Überwachung

- Automations and Communications Mining™

- Entwickler (Developer)

- Verwenden der API

- API-Tutorial

- Quellen

- Datasets

- Anmerkungen

- Anhänge (Attachments)

- Vorhersagen

- Erstellen Sie einen Stream

- Aktualisieren Sie einen Stream

- Rufen Sie einen Stream nach Namen ab

- Rufen Sie alle Streams ab

- Löschen Sie einen Stream

- Ergebnisse aus Stream abrufen

- Kommentare aus einem Stream abrufen (Legacy)

- Bringen Sie einen Stream vor

- Einen Stream zurücksetzen

- Kennzeichnen Sie eine Ausnahme

- Entfernen Sie das Tag einer Ausnahme

- Prüfungsereignisse

- Alle Benutzer abrufen

- Hochladen von Daten

- Herunterladen von Daten

- Exchange Integration mit einem Azure-Dienstbenutzer

- Exchange-Integration mit der Azure-Anwendungsauthentifizierung

- Exchange-Integration mit Azure Application Authentication und Graph

- Abrufen von Daten für Tableau mit Python

- Elasticsearch-Integration

- Allgemeine Feldextraktion

- Selbst gehostete Exchange-Integration

- UiPath® Automatisierungs-Framework

- Offizielle UiPath®-Aktivitäten

- Wie Maschinen lernen, Wörter zu verstehen: eine Anleitung zu Einbettungen in NLP

- Eingabeaufforderungsbasiertes Lernen mit Transformers

- Ef Robots II: Wissensdegesterration und Feinabstimmung

- Effiziente Transformer I: Warnmechanismen

- Tief hierarchische, nicht überwachte Absichtsmodellierung: Nutzen ohne Trainingsdaten

- Beheben von Anmerkungsverzerrungen mit Communications Mining™

- Aktives Lernen: Bessere ML-Modelle in weniger Zeit

- Auf Zahlen kommt es an – Bewertung der Modellleistung mit Metriken

- Darum ist Modellvalidierung wichtig

- Vergleich von Communications Mining™ und Google AutoML für Conversation Data Intelligence

- Lizenzierung

- Häufige Fragen und mehr

Wichtig :

Es kann 1–2 Wochen dauern, bis die Lokalisierung neu veröffentlichter Inhalte verfügbar ist.

Communications Mining-Benutzerhandbuch

Letzte Aktualisierung 9. März 2026

Kernkonzepte

Dieser Abschnitt bietet einen Überblick über die wichtigsten Plattformkonzepte.

Um mehr über die Plattform aus der Sicht des Endbenutzers zu erfahren, sehen Sie sich das Benutzerhandbuch von Communications Mining™.

| Konzept | Beschreibung | Beispiel |

|---|---|---|

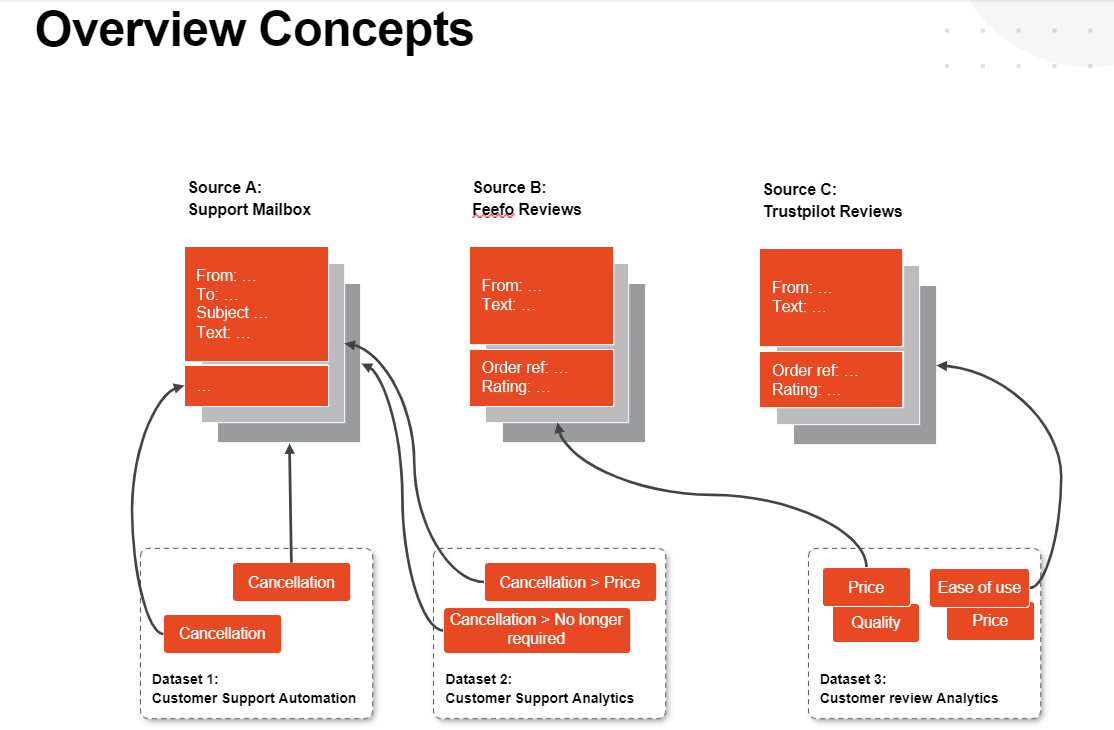

| Quelle | In Communications Mining™ sind Daten in Datenquellen oder Quellen organisiert. In der Regel entspricht eine Quelle einem Kanal. Ein E-Mail-Postfach, die Ergebnisse einer Umfrage oder eine Reihe von Kundenrezensionen sind Beispiele für Daten, die als Datenquelle in Communications Mining hochgeladen werden können. Mehrere Quellen können kombiniert werden, um ein Modell zu erstellen, daher ist es am besten, sich für die Seite mehrerer Quellen anstatt für eine einzelne Mon Aktivitäten zu entscheiden. | Das Diagramm zeigt E-Mail-Daten (Quelle A, die einzelne E-Mails enthält) und Kundenbewertungsdaten (Quellen B und C, die einzelne Kundenbewertungen enthalten). Die Kundenüberprüfungsdaten werden basierend auf der Datenherkunft in zwei Quellen aufgeteilt, aber zum Erstellen eines gemeinsamen Modells in einem einzigen Dataset kombiniert. |

| Kommentar (Comment) | Innerhalb von Quellen wird jeder einzelne Teil der Textkommunikation als Kommentar dargestellt. Ein Kommentar hat immer eine ID, einen Zeitstempel und einen Textkörper sowie zusätzliche Felder, die davon abhängen, welchen Datentyp er repräsentiert. Beispielsweise haben E-Mails die erwarteten E-Mail-Felder wie Von, An, Cc usw. | Das Diagramm zeigt, wie die verfügbaren Kommentarfelder von den verschiedenen Kommentartypen verwendet werden. Beispielsweise enthält das Feld Von in einem E-Mail-Kommentar die Absenderadresse, während es in einem Kundenrezensionen den Reviewautor enthält. Die Metadatenfelder, die am unteren Rand jedes Kommentars angezeigt werden, sind benutzerdefiniert. Beachten Sie, dass wir denselben Satz von Feldern für beide Kundenrezensionen verwenden: Da wir sie zu einem einzigen Dataset kombinieren möchten, sollten die Daten konsistent sein, um eine gute Modellleistung sicherzustellen. |

| Dataset | Mit einem Dataset können Sie eine oder mehrere Quellen mit Anmerkungen versehen, um ein Modell zu erstellen. Eine Quelle kann in mehreren Datasets enthalten sein. Der Satz aller Beschriftungen in einem Dataset wird als Taxonomie bezeichnet. | Das Diagramm zeigt zwei Datasets, die auf den Support-Postfach-Daten aufbauen, und ein Dataset, das die Kundenrezensionen kombiniert. Beachten Sie, dass Dataset 1 und Dataset 2 zwar auf denselben Daten basieren, ihre Beschriftungstaxonomie jedoch unterschiedlich ist, da ihre Anwendungsfälle, d. h. Analysen und Automatisierung, unterschiedliche Beschriftungssätze erfordern. |

| Modell | Das Modell wird kontinuierlich aktualisiert, wenn Benutzer weitere Daten kommentieren. Um konsistente Vorhersagen zu erhalten, muss bei der Abfrage des Modells eine Modellversionsnummer angegeben werden. | |

| Label | Beschriftungen werden beim Training eines Modells angewendet und zurückgegeben, wenn das Modell nach Vorhersagen abgefragt wird. Wenn Beschriftungen als Vorhersagen zurückgegeben werden, haben sie einen zugehörigen Konfidenzwert, der angibt, wie wahrscheinlich das Modell annimmt, dass die Vorhersage zutrifft. Um die Vorhersage in eine Ja- oder Nein-Antwort umzuwandeln, muss die Konfidenzbewertung anhand eines Schwellenwerts überprüft werden, der als Kompromiss zwischen Genauigkeit und Rückruf gewählt wird. | Beschriftungen werden von Communications Mining-Benutzern beim Training des Modells zugewiesen. Die Benutzeroberfläche von Communications Mining hilft dem Benutzer, die relevantesten Kommentare mit Anmerkungen zu versehen, sicherzustellen, dass Beschriftungen konsistent angewendet werden und dass genügend Kommentare mit Anmerkungen versehen sind, um ein gut funktionierendes Modell zu erzeugen. |