- Primeros pasos

- Instalación y configuración

- Requisitos de hardware y software

- Acerca de las Licencias de Precios Unificados

- Acerca de las Licencias Flexibles

- Activar Studio

- Actualizar Studio

- Parámetros de la línea de comandos

- Aplicaciones y tecnologías compatibles

- Habilitación de Gmail para actividades de correo electrónico

- Deshabilitar la telemetría

- Studio Executables

- Proyectos de automatización

- Dependencias

- Tipos de flujos de trabajo

- Flujo de control

- Comparación de archivos

- Mejores prácticas de automatización

- Integración del control de código fuente

- Depuración

- Registro

- La herramienta de diagnóstico

- Analizador de flujo de trabajo

- Acerca del analizador de flujo de trabajo

- ST-NMG-001: convención sobre nombres de variables

- ST-NMG-002: convención de nombres de argumentos

- ST-NMG-004: duplicación de nombres de visualización

- ST-NMG-005: anulación de variables

- ST-NMG-006: argumentos de anulación de variables

- ST-NMG-008: longitud variable excedida

- ST-NMG-009: variables de datos prefijados

- ST-NMG-011: argumentos de prefijo Datatable

- ST-NMG-012: valores predeterminados de los argumentos

- ST-NMG-016: longitud del argumento excedida

- ST-NMG-017: el nombre de la clase coincide con el espacio de nombres predeterminado

- ST-DBP-002: recuento de Argumentos elevado

- ST-DBP-003: bloque de Catch vacío

- ST-DBP-007: múltiples capas de diagramas de flujo

- ST-DPB-010: varias instancias de [flujo de trabajo] o [caso de prueba]

- ST-DBP-020: propiedades de salida no definidas

- ST-DBP-021: tiempo de espera codificado

- ST-DBP-023: flujo de trabajo vacío

- ST-DBP-024: comprobación de actividad de persistencia

- ST-DBP-025: requisito previo para la serialización de variables

- ST-DBP-027: mejor práctica de persistencia

- ST-DBP-028: requisito de serialización de argumentos

- ST-USG-005 - Propiedades de la actividad codificadas

- ST-USG-009: variables no utilizadas

- ST-USG-010: dependencias sin utilizar

- ST-USG-014: restricciones de los paquetes

- ST-USG-017: modificador de parámetro no válido

- ST-USG-020: mensajes de registro mínimos

- ST-USG-024: guardado sin usar para más adelante

- ST-USG-025: uso incorrecto de los valores guardados

- ST-USG-026: restricciones de actividad

- ST-USG-027: paquetes necesarios

- ST-USG-028: Restringir la invocación de plantillas de archivo

- ST-USG-032 - Etiquetas obligatorias

- ST-USG-034 - URL Automation Hub

- Variables

- Argumentos

- Espacios de nombres importados

- Automatizaciones codificadas

- Introducción

- Registrar servicios personalizados

- Contextos Antes y Después

- Generando código

- Generar casos de prueba codificados a partir de casos de prueba manuales

- Integración de OpenAI con los flujos de trabajo codificados

- Solicita un préstamo con UiBank

- Generación de colas con flujos de trabajo codificados y API de Orchestrator

- Utilizar proyectos de biblioteca importados en automatizaciones codificadas

- Uso de la autenticación de dos factores dentro de automatizaciones codificadas

- Conectar a MongoDB Atlas con automatizaciones codificadas

- Solución de problemas

- Automatización atendida basada en desencadenadores

- Repo. de objetos

- La herramienta ScreenScrapeJavaSupport

- Extensiones

- Acerca de las extensiones

- Herramienta SetupExtensions

- UiPathRemoteRuntime.exe no se está ejecutando en la sesión remota

- UiPath Remote Runtime impide que la sesión de Citrix pueda cerrarse

- UiPath Remote Runtime provoca una fuga de memoria

- Las versiones del paquete UiPath.UIAutomation.Activities y UiPath Remote Runtime no coinciden

- La extensión de UiPath necesaria no está instalada en la máquina remota

- Configuración de la resolución de la pantalla

- Políticas de grupo

- No se puede comunicar con el navegador

- La extensión de Chrome se elimina automáticamente

- Es posible que la extensión se haya dañado

- Comprueba si la extensión para Chrome está instalada y habilitada

- Check if ChromeNativeMessaging.exe is running

- Check if ComSpec variable is defined correctly

- Habilitar el acceso a las URL de archivos y el modo de incógnito

- Multiple browser profiles

- Group Policy conflict

- Known issues specific to MV3 extensions

- Lista de extensiones para Chrome

- Extensión de Chrome en Mac

- Políticas de grupo

- No se puede comunicar con el navegador

- La extensión de Edge se elimina automáticamente

- Es posible que la extensión se haya dañado

- Check if the Extension for Microsoft Edge is installed and enabled

- Check if ChromeNativeMessaging.exe is running

- Check if ComSpec variable is defined correctly

- Enable access to file URLs and InPrivate mode

- Multiple browser profiles

- Group Policy conflict

- Known issues specific to MV3 extensions

- Lista de extensiones para Edge

- Extensión para Safari

- Extensión para VMware Horizon

- Extensión para Amazon WorkSpaces

- Complemento SAP Solution Manager

- Add-in de Excel

- Pruebas de Studio

- Introducción

- Trabajar con casos de prueba manuales

- Plantillas de ejecución

- Solución de problemas

- Acerca de la resolución de problemas

- Errores de compilación del ensamblado

- Compatibilidad y limitaciones de Microsoft App-V

- Solución de problemas de Internet Explorer x64

- Problemas de Microsoft Office

- Identificación de elementos de la interfaz de usuario en PDF con opciones de accesibilidad

- Reparar Soporte Active Accessibility

- Validation of large Windows-legacy projects takes longer than expected

Guía del usuario de Studio

Trabajar con casos de prueba manuales

Una vez que hayas establecido una conexión con una instancia de Test Manager y un proyecto de Studio, puedes navegar al panel Explorador de pruebas. En primer lugar, puedes transformar las pruebas manuales dentro del proyecto asociado en casos de prueba de código bajo o codificados. En segundo lugar, puedes crear casos de prueba codificados utilizando nuestras características de IA impulsadas por Autopilot Name. Si es necesario, puedes revisar estas pruebas manuales en Test Manager haciendo doble clic en el caso de prueba en el panel Explorador de pruebas antes de automatizarlas.

Generar casos de prueba utilizando IA

Puedes generar casos de prueba totalmente automatizados utilizando IA generativa impulsada por Nombre de Autopilot.

Generar casos de prueba codificados utilizando IA

Antes de comenzar, consulta las prácticas recomendadas de probar automatización para asegurarte de generar de forma efectiva los casos de prueba codificados.

Prerequisites:

- Conecta Studio a un proyecto de Test Manager.

- Crea elementos en el repositorio de objetos que reflejen los elementos de la interfaz de usuario de las pruebas manuales.

Nota:

Autopilot utiliza elementos del repositorio de objetos para automatizar elementos de la IU en pasos de prueba. Los elementos se emplean en las API como

IElementDescriptors.

Puedes generar casos de prueba codificados desde Studio IDE o desde el panel Test Explorer.

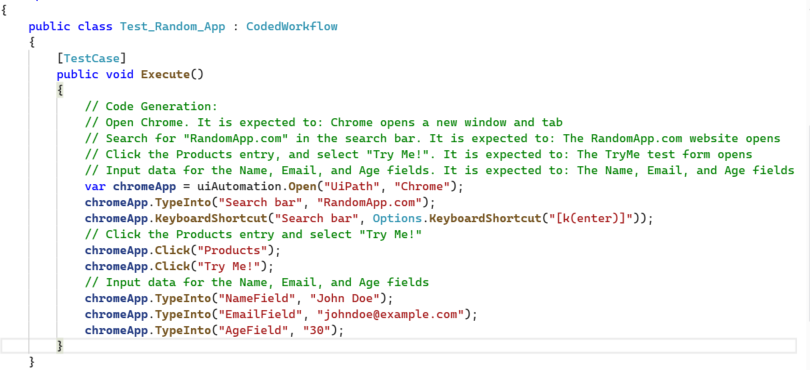

Para generar un caso de prueba codificado desde el Studio IDE, puedes crear un nuevo caso de prueba codificado y emplear Autopilot para generar código para este.Consulta Generación de código para obtener más información sobre las formas de generar código.

Para generar el caso de prueba codificado desde el panel Explorador de pruebas, sigue estos pasos:

-

En el panel Explorador de pruebas, selecciona Casos de prueba manuales para mostrar los casos de prueba manuales que puedes convertir en automatizaciones.

-

Haz clic con el botón derecho en un caso de prueba manual y selecciona Generar caso de prueba codificado con Autopilot. El resultado será un caso de prueba codificado que utiliza las API de UiPath para generar el código para automatizar la prueba manual completa. Los pasos manuales se muestran como comentarios al principio del caso de prueba.

Generar casos de prueba de código bajo utilizando IA

Antes de comenzar, consulta las mejores prácticas de automatización de pruebas impulsadas por IA para garantizar que generas de forma efectiva los casos de prueba de bajo código.

Prerequisites:

- Conecta Studio a un proyecto de Test Manager.

- Crea elementos en el repositorio de objetos que reflejen los elementos de la interfaz de usuario de las pruebas manuales.

Nota:

Autopilot utiliza elementos del repositorio de objetos para automatizar elementos de la IU en pasos de prueba.

Puedes generar casos de prueba de low-code desde el panel Diseñador o desde el panel Explorador de pruebas.

Para generar casos de prueba de low-code desde el panel Explorador de pruebas, sigue estos pasos:

- En el panel Explorador de pruebas, selecciona Casos de prueba manuales para mostrar los casos de prueba manuales que puedes convertir en automatizaciones.

- Haz clic con el botón derecho en un caso de prueba manual y selecciona Generar caso de prueba con Autopilot. El resultado será un caso de prueba low-code que utiliza actividades para generar la automatización para toda la prueba manual.

Para generar casos de prueba low-code desde el panel Diseñador, sigue estos pasos:

- Abre tu caso de prueba de bajo código en blanco y selecciona generar con Autopilot desde el Panel de Diseñador. Aparece un campo de texto Escribir anotación, que permite introducir tus instrucciones.

- Introduce los pasos de prueba necesarios y luego selecciona Generar para iniciar la generación de tu caso de prueba. Si lo deseas, puedes guardar las instrucciones y volver a ellas más tarde. Selecciona Guardar si deseas guardar las instrucciones.

Nota:

Puedes utilizar estos pasos para crear actividades en bloques Hacer o dentro de los cuerpos de otras actividades.

Figura 1. Escribir las instrucciones para Autopilot en el campo de texto Escribir anotación

Para generar una única actividad, sigue estos pasos:

- Selecciona Añadir actividad o utiliza el atajo

Ctrl + Shift + Tpara abrir la barra de búsqueda de Studio. - En la barra de búsqueda de Studio, introduce tus instrucciones.

- Selecciona Generar con Autopilot, al final de la lista de la barra de búsqueda. Este comando te permite utilizar lenguaje natural para generar pasos de automatización, incluidos los pasos de prueba, según tu entrada.

Crear un caso de prueba codificado a partir de un caso de prueba manual

Puedes crear un caso de prueba codificado a partir de una prueba manual, lo que da como resultado que Studio genere un caso de prueba codificado con el nombre de la prueba manual.

Prerequisites:

- Conectar a Test Manager:

- En el encabezado de Studio, haz clic en Test Manager.

- Haz clic en Configuración de Test Manager.

- Introduce la URL base de tu instancia de Test Manager y haz clic en Conectar.

- En Proyecto predeterminado, selecciona el proyecto en el que quieres trabajar. Este proyecto debe incluir las pruebas manuales con las que deseas trabajar.

Pasos

-

Abre el panel Test Explorer.

-

Haz clic con el botón derecho del ratón en un caso de prueba manual de la lista de casos de prueba de tu proyecto predeterminado.

-

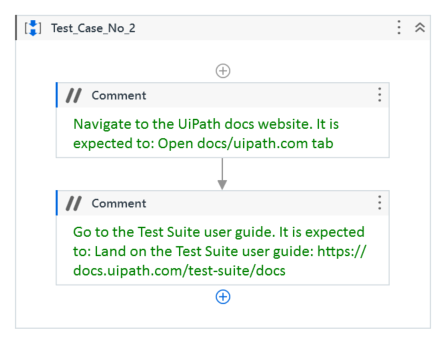

Haz clic en Crear caso de prueba codificado. Resultado: se crea automáticamente un nuevo caso de prueba codificado, que tiene el mismo nombre que la prueba manual. Este caso de prueba codificado muestra los pasos manuales como comentarios.

Crear un caso de prueba de bajo código a partir de un caso de prueba manual

Puedes generar un caso de prueba de poco código a partir de una prueba manual con los pasos manuales que se muestran como actividades de Comentario.

Pasos

-

Conecta Studio a un proyecto de Test Manager.

-

En el panel del Explorador de Pruebas, selecciona Casos de prueba manuales para mostrar los casos de prueba manuales que puedes convertir en casos de prueba de low-code.

-

Haga clic derecho en un caso de prueba manual y selecciona Crear caso de prueba. El resultado es un caso de prueba de poco código que coloca los pasos manuales como actividades de comentario dentro del archivo XAML.

- Generar casos de prueba utilizando IA

- Generar casos de prueba codificados utilizando IA

- Generar casos de prueba de código bajo utilizando IA

- Crear un caso de prueba codificado a partir de un caso de prueba manual

- Pasos

- Crear un caso de prueba de bajo código a partir de un caso de prueba manual

- Pasos